Best practice e risoluzione dei problemi

Queste best practice e questi suggerimenti per la risoluzione dei problemi aiutano a utilizzare al meglio Cognite Power BI connector.

Best practice relative alle prestazioni

Le prestazioni di Cognite Power BI connector dipendono dai tipi di risorse di Cognite Data Fusion (CDF) a cui si accede. Ad esempio, la lettura di punti dati 1M richiede approssimativamente da 2:30 a 3:00 minuti (6000 punti dati al secondo). Ogni richiesta completa richiede circa 120 ms e il connettore aggiunge una media di 20 ms alle richieste di CDF.

Seguire queste best practice generali per assicurarsi di ottenere le prestazioni più affidabili:

- Non utilizzare le espressioni

ORo l'espansione delle tabelle. - Se possibile, utilizzare più query.

- Utilizzare l'aggiornamento incrementale.

- Se possibile, eseguire il partizionamento dei set di dati.

- Conservare solo i dati necessari. Rimuovere i dati e le colonne non necessari.

- Mantenere i dati storici in un report separato se i dati non sono necessari quotidianamente. Aggiornare il report dei dati storici quando i dati sono necessari.

- Ridurre il numero di calcoli/operazioni all'inizio e cercare di fare il più possibile nella fase di modellazione dei dati.

Scrittura di query performanti

Il servizio OData accetta più richieste simultanee e le elabora in parallelo. Inoltre, quando possibile, Power BI recapita più query simultaneamente.

Pertanto, è preferibile scrivere e utilizzare più query anziché una sola query complessa con, ad esempio, espressioni OR o espansioni. Una sola query complessa deve essere iterata in sequenza, aggiungendo la latenza di andata e ritorno per ogni richiesta.

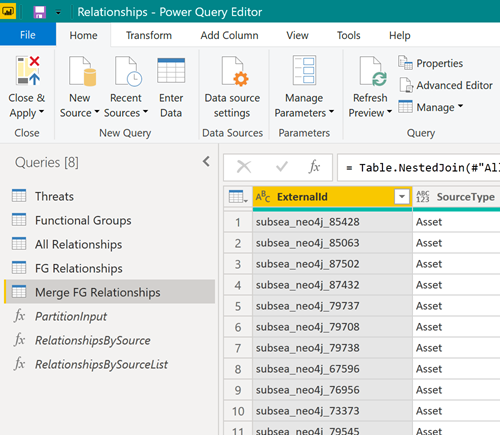

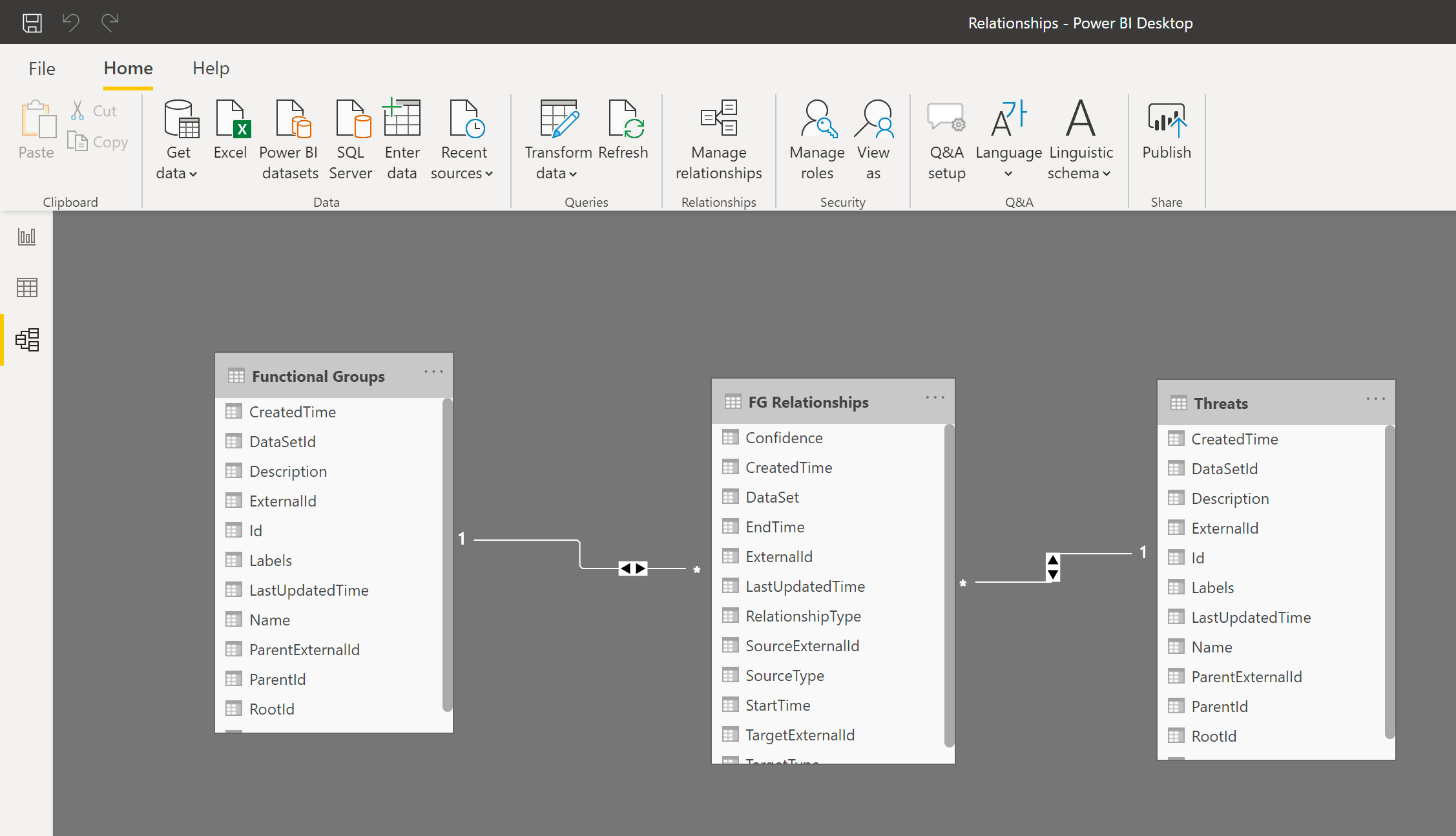

Provare, invece, a scaricare i dati utilizzando più query:

Successivamente, unire le tabelle risultanti nel modello dati di Power BI per utilizzare le tabelle come se fossero una sola:

Utilizzo dell'aggiornamento incrementale

L'aggiornamento incrementale consente di aggiornare set di dati di grandi dimensioni in Power BI con i seguenti vantaggi:

- Solo i dati modificati devono essere aggiornati.

- Non è necessario mantenere attive connessioni prolungate ai sistemi di origine.

- Aggiornando una quantità minore di dati si riduce l'utilizzo totale di memoria e di altre risorse.

Ulteriori informazioni sull'aggiornamento incrementale.

Partizionamento di set di dati di grandi dimensioni

Se è necessario scaricare set di dati di grandi dimensioni, provare a partizionare il set di dati e a creare una query distinta per leggere ciascuna partizione. Power BI elabora più query simultaneamente e il partizionamento del set di dati può migliorare in modo significativo le prestazioni.

Ad esempio, se si leggono punti dati degli ultimi due anni, provare a suddividere una query in due, in modo che ognuna legga un solo anno di dati. Poi, unire (concatenare) le tabelle in Power BI.

Cancellazione della cache

Power BI memorizza nella cache il manifesto del servizio che descrive lo schema del servizio OData. Quando il connettore o il servizio OData viene aggiornato, potrebbe essere necessario cancellare la cache di Power BI per forzare Power BI a rileggere il manifesto del servizio.

Per cancellare la cache:

-

In

Power BI Desktop, selezionare File > Opzioni e impostazioni > Opzioni > Caricamento dati. -

In Opzioni di gestione della cache dei dati selezionare Cancella cache.

Denominazione delle proprietà nei metadati e nei dati CDF RAW

Le chiavi delle proprietà per i metadati e l'area di gestione temporanea di CDF (RAW) devono essere identificatori validi e possono contenere solo lettere, numeri o caratteri di sottolineatura. Il servizio OData riscrive qualsiasi altro carattere in un carattere di sottolineatura. Per ottenere risultati migliori e più prevedibili, assicurarsi che i dati inseriti seguano la convenzione di denominazione per le chiavi delle proprietà: ^[a-zA-Z][_a-za-z0-9]\*[a-zA-Z0-9]\$.

Risoluzione dei problemi

Trovare informazioni per risolvere i problemi utilizzando CDF come origine dati in Power BI.

Le query richiedono troppo tempo

Un progetto CDF pu�ò contenere centinaia di milioni di righe di dati, pertanto non è fattibile caricarle tutte in Power BI. Se l'esecuzione della query richiede ore, è probabile che si stia cercando di caricare una quantità eccessiva di dati.

Utilizzare le informazioni nell'articolo sul filtro per limitare la quantità di dati caricati in Power BI.

Non si ottengono tutti i risultati

Se si ottengono meno risultati del previsto, è possibile che si stia utilizzando una funzione di filtro che CDF non supporta, ad esempio startswith nella colonna Nome per Serie temporale.

Per ulteriori informazioni, vedere Filtro supportato per le risorse CDF.

Impossibile recuperare valori minimi da CDF RAW

Se si utilizzano dati dall'area di gestione temporanea di CDF, CDF RAW, in Power BI, potrebbero verificarsi problemi nel recupero di numeri piccoli in notazione esponenziale.

CDF RAW non ha uno schema, ma le librerie OData in Power BI tentano di selezionare il formato corretto dei dati. Attualmente, Power BI sceglie il decoder errato per i numeri bassi in notazione esponenziale, pertanto si potrebbe ricevere un errore simile al seguente:

DataSource,Error: OData: Cannot convert the literal '2.89999206870561 to the expected type 'Edm.Decimal',

Per risolvere il problema, inserire i valori in CDF RAW come stringhe e non come numeri, quindi convertire la stringa in numeri in Power BI, ad esempio utilizzando la funzione Decimal.From di Power Query M. La precisione non diminuirà e poiché la maggior parte dei decoder JSON accetta stringhe al posto dei numeri, i client che prevedono numeri funzioneranno comunque.