Aanbevolen procedures en probleemoplossing

Haal het maximale uit de Cognite Power BI connector met de volgende aanbevolen procedures en tips voor probleemoplossing.

Aanbevolen procedures voor prestaties

De prestaties van de Cognite Power BI connector hangen af van de Cognite Data Fusion (CDF)-resourcetypen waartoe u toegang hebt. Het lezen van 1 miljoen gegevenspunten duurt bijvoorbeeld ongeveer 2,5 tot 3 minuten (6000 gegevenspunten per seconde). Elke volledige aanvraag duurt gemiddeld 120 ms, plus gemiddeld 20 ms voor de connector per CDF-aanvraag.

Volg deze aanbevolen procedures om de beste en meest betrouwbare prestaties te waarborgen:

- Gebruik geen expressies met

ORof uitvouwbare tabellen. - Gebruik indien mogelijk meerdere query's.

- Gebruik incrementeel vernieuwen.

- Partitioneer uw gegevenssets indien mogelijk.

- Bewaar alleen de gegevens die u nodig hebt. Verwijder onnodige kolommen en gegevens.

- Bewaar historische gegevens in een apart rapport als u de gegevens niet dagelijks nodig hebt. Vernieuw het rapport met historische gegevens wanneer u de gegevens nodig hebt.

- Verminder het aantal berekeningen/bewerkingen in de frontend en probeer zoveel mogelijk in de gegevensmodellering te doen.

Effectieve query's schrijven

De OData-service accepteert meerdere gelijktijdige aanvragen en verwerkt de aanvragen parallel. Power BI verzendt indien mogelijk ook meerdere query's tegelijkertijd.

Daarom is het beter om meerdere query's te gebruiken in plaats van één complexe query met bijvoorbeeld OR-expressies of uitvouwbare items. Eén complexe query moet opeenvolgend worden herhaald met de toegevoegde retourlatentie voor elke aanvraag.

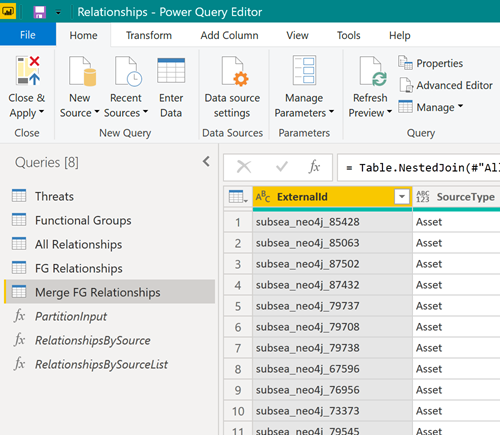

Probeer in plaats daarvan de gegevens te downloaden met behulp van meerdere query's:

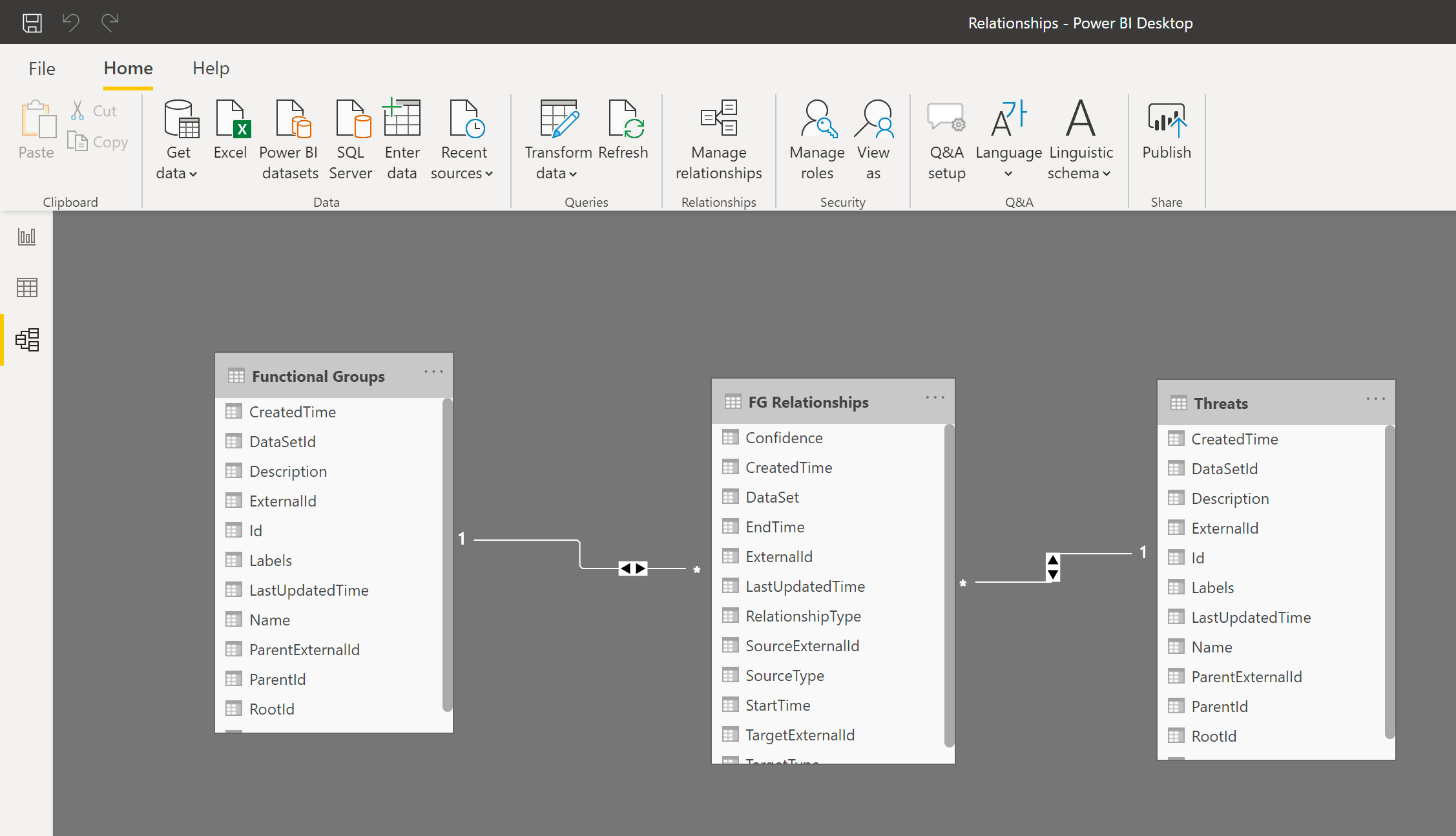

Voeg vervolgens de resulterende tabellen samen in het Power BI-gegevensmodel zodat u met de tabellen kunt werken alsof het één enkele tabel is:

Incrementeel vernieuwen gebruiken

Incrementeel vernieuwen maakt grote gegevenssets in Power BI mogelijk. Dit heeft de volgende voordelen:

- Alleen gegevens die zijn gewijzigd, hoeven te worden vernieuwd.

- U hoeft geen langdurige verbindingen met bronsystemen te onderhouden.

- Er zijn minder gegevens om te vernieuwen, dus geheugen en andere bronnen worden minder belast.

Meer informatie over incrementeel vernieuwen.

Grote gegevenssets partitioneren

Als u grote gegevenssets moet downloaden, kunt u de gegevensset partitioneren en een afzonderlijke query gebruiken om elke partitie te lezen. Power BI kan meerdere query's tegelijk verwerken, en door partitionering van de gegevensset worden de prestaties aanzienlijk verbeterd.

Als u bijvoorbeeld gegevenspunten van de afgelopen twee jaar leest, kunt u proberen de query op te splitsen in twee query's, waarbij elke query één jaar aan gegevens leest. Voeg vervolgens de tabellen samen in Power BI.

De cache wissen

Het servicemanifest met een beschrijving van het schema van de OData-service wordt opgeslagen in de cache van Power BI. Wanneer er een upgrade wordt uitgevoerd van de connector of OData-service, moet u mogelijk de cache van Power BI wissen om Power BI te dwingen het servicemanifest opnieuw te lezen.

De cache wissen:

-

Ga naar

Power BI Desktopen selecteer Bestand > Opties en instellingen > Opties > Dataload. -

Ga naar Opties voor gegevenscachebeheer en selecteer Cache wissen.

Naamgeving van eigenschappen in de metagegevens en CDF RAW

Eigenschapssleutels voor metagegevens en het CDF-faseringsgebied (RAW) moeten geldige id's zijn en mogen alleen letters, cijfers of onderstrepingstekens bevatten. Elk ander teken wordt vervangen door een onderstrepingsteken in de OData-service. Voor de beste en meest voorspelbare resultaten moeten de ingevoerde gegevens de volgende naamgevingsconventie voor eigenschapssleutels volgen: ^[a-zA-Z][_a-za-z0-9]\*[a-zA-Z0-9]\$.

Probleemoplossing

Vind informatie met oplossingen voor problemen bij het gebruik van CDF als gegevensbron in Power BI.

Query's duren te lang

Een CDF-project kan honderden miljoenen gegevensrijen bevatten en het is niet haalbaar om deze allemaal te laden in Power BI. Als het uren duurt om uw zoekopdracht uit te voeren, probeert u waarschijnlijk te veel gegevens te laden.

Gebruik de informatie in het artikel Filteren om te weten hoe u beperkingen kunt instellen voor de hoeveelheid gegevens die worden geladen in Power BI.

Niet alle resultaten worden opgehaald

Als u minder resultaten krijgt dan verwacht, gebruikt u mogelijk een filterfunctie die niet wordt ondersteund door CDF, zoals startswith in de kolom Naam voor TimeSeries.

Ga voor meer informatie naar Ondersteunde filters voor CDF-resources.

Kan geen minimale waarden ophalen van CDF RAW

Als u gegevens uit het CDF-faseringsgebied CDF RAW in Power BI gebruikt, kunnen er mogelijk problemen optreden bij het ophalen van kleine getallen in exponentiële notatie.

CDF RAW heeft geen schema, maar de OData-bibliotheken binnen Power BI proberen de juiste indeling voor de gegevens te selecteren. Momenteel kiest Power BI de verkeerde decoder voor kleine getallen in exponentiële notatie, en mogelijk krijgt u een foutmelding met de volgende strekking:

DataSource,Error: OData: Cannot convert the literal '2.89999206870561 to the expected type 'Edm.Decimal',

U kunt dit probleem als volgt oplossen: voer de waarden in CDF RAW in als tekenreeksen in plaats van getallen en converteer de tekenreeksen vervolgens terug naar getallen in Power BI, bijvoorbeeld via de functie Decimal.From van Power Query M. De gegevens blijven even nauwkeurig, en omdat de meeste JSON-decoders tekenreeksen accepteren in plaats van getallen, worden deze tekenreeksen toch nog correct verwerkt door clients die met getallen werken.